Robot hình người với thiết kế lấy cảm hứng từ con người luôn là một trong những định hướng chính trong phát triển robot. Loại robot này rất hữu ích để con người thực hiện các công việc hàng ngày như giao tiếp, phục vụ, chỉ dẫn và hướng dẫn nơi công cộng.

Vấn đề ở robot

Tuy nhiên, có một điểm yếu “bẩm sinh” mà chú robot này gặp phải, đó là khả năng mang và vác đồ vật liên quan đến các yếu tố như hình dạng, trọng lượng và kích thước của vật thể.

Trên thực tế, nhiều robot hình người hiện đại đã có khả năng thu thập các vật thể nhỏ và nhẹ. Tuy nhiên, thường không thể nâng các vật nặng hoặc cồng kềnh. Nếu va chạm với một vật quá lớn hoặc nặng, robot sẽ có thể ngã hoặc nâng vật lên không nổi.

Để giải quyết vấn đề này, các nhà nghiên cứu tại Đại học Johns Hopkins và Đại học Quốc gia Singapore (NUS) đã thực hiện thành công phương pháp cho phép robot xác định xem chúng có thể tự nâng mình lên hay không. Là một đối tượng có đặc tính vật lý chưa biết hay không.

“Chúng tôi đặc biệt quan tâm đến cách robot hình người có thể chứng minh khả năng nâng vật; mà không cần biết các đặc tính vật lý của chúng.

Để đối phó với một nhiệm vụ phức tạp như vậy; trước tiên robot phải có khả năng xác định các thông số vật chất của vật thể; sau đó là có đường đi an toàn và ổn định để nâng”. Tiến sĩ Yuanfeng Han, một thành viên của nhóm nghiên cứu cho biết.

Vấn đề khắc phục

Quá trình robot tạo ra quỹ đạo chuyển động phù hợp; cho phép nó nâng các vật thể nghe có vẻ đơn giản nhưng trên thực tế đòi hỏi khá nhiều tính toán chuyên sâu cũng như trình độ công nghệ mới nhất; giống như cơ thể người cần sự tham gia của nhiều nhóm cơ chỉ để thực hiện một hành động đơn giản.

Điều này có nghĩa là đối với một vật thể quá nặng hoặc quá cồng kềnh; nếu không thể tính toán chính xác, robot sẽ không thể thực hiện được nhiệm vụ.

“Hãy nghĩ về tình huống thực tế đối với con người; khi chúng ta cố gắng suy luận về việc liệu mình có thể nhấc một vật nặng lên; chẳng hạn như một quả tạ hay không, trước tiên chúng ta cần “tương tác” với quả tạ để có được cảm giác nhất định về nó.

Sau đó, dựa trên kinh nghiệm và ước lượng cá nhân; chúng ta sẽ biết được liệu mình có thể nâng nổi quả tạ đó hay không. Tương tự, phương pháp của chúng tôi bắt đầu bằng cách xây dựng một bảng quỹ đạo; bảng này lưu lại các chuyển động nâng hợp lệ khác nhau cho robot; tương ứng với một loạt các thông số vật lý của vật thể, bằng cách sử dụng mô phỏng.

Sau đó, robot sẽ coi bảng này là kiến thức kinh nghiệm mà nó có được; và dựa vào đó để đưa ra quyết định chính xác nhất”; đại diện nhóm nghiên cứu giải thích.

Kỹ thuật tiên tiến

Kỹ thuật này, về cơ bản; cho phép robot nhận biết được các thông số quán tính của một vật thể sau khi tương tác nhanh với nó. Sau đó, robot sẽ “nhìn lại” bảng quỹ đạo vật thể mà nó đã được đào tạo; và kiểm tra xem trong đó có bao gồm những chuyển động phù hợp cho phép nó nâng được một vật thể; với các thông số ước tính này hay không.

Nếu có, việc nâng vật thể sẽ được coi là khả thi; và robot sẽ tiến hành chuyển động tương ứng ngay lập tức. Ở trường hợp ngược lại, robot coi sẽ coi đây là nhiệm vụ vượt quá khả năng của nó; và bỏ qua để tránh những thiệt hại không đáng có.

Nhìn chung, toàn bộ quá trình này được đảm nhận bởi một thuật toán AI dựa trên tương tác vật lý; giúp robot tương tác với vật thể một cách an toàn; và ước tính các thông số quán tính cần thiết.

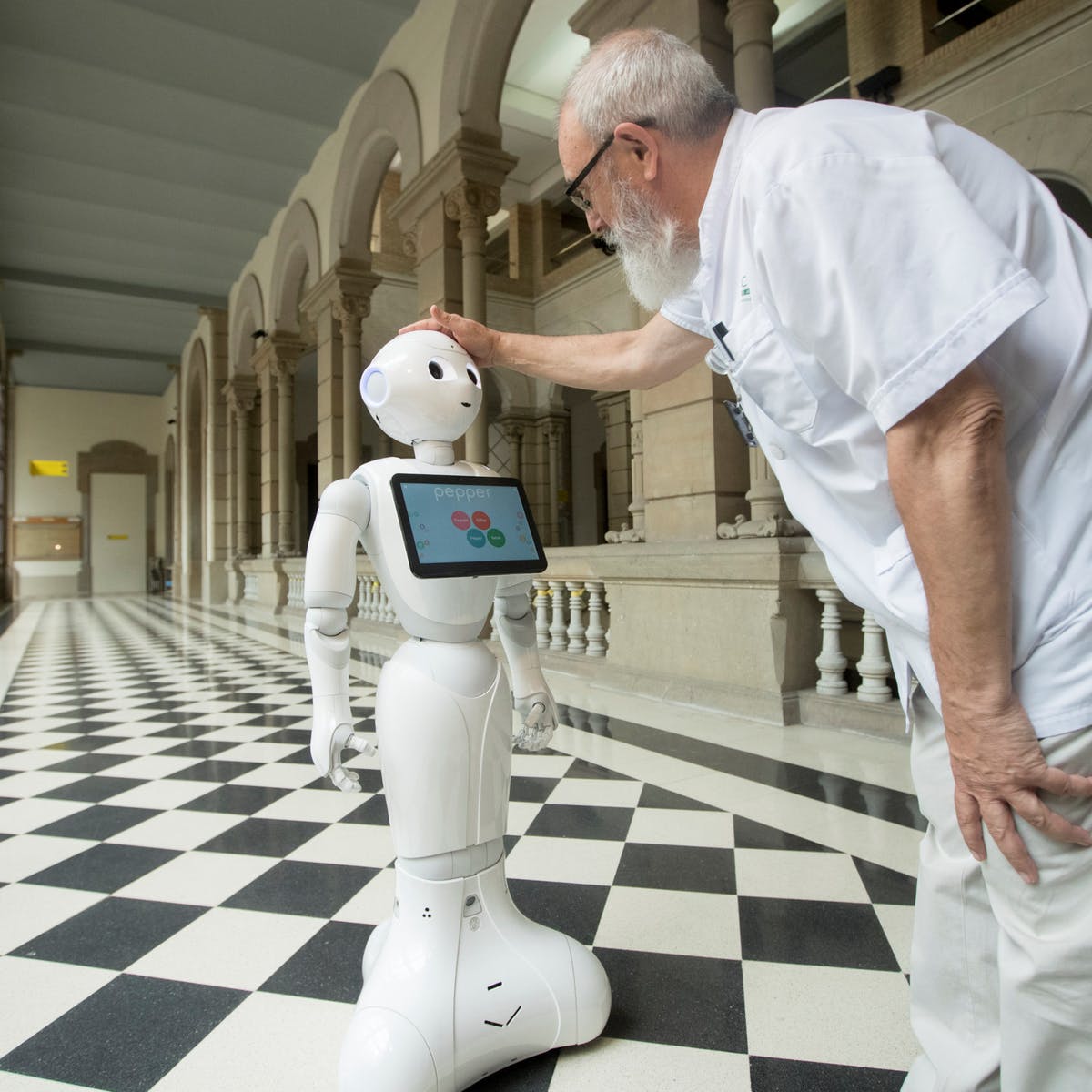

Nhóm nghiên cứu đã tiến hành đánh giá hiệu quả của kỹ thuật mới này; trong một loạt các thử nghiệm bằng cách sử dụng NAO; một robot hình người nổi tiếng do SoftBank Robotics phát triển. Trong các thử nghiệm, NEO đã có thể xác định nhanh chóng các vật thể; mà nó không thể hoặc rất khó nâng được với độ chính xác cao.

Trong tương lai, kỹ thuật này có thể được áp dụng cho các robot hình người khác; để làm cho chúng trở nên đáng tin cậy; và hiệu quả hơn trong việc hoàn thành các nhiệm vụ liên quan đến cơ học; từ đó có thể trở thành trợ thủ đắc lực cho con người trong nhiều tình huống hơn.

Trí tuệ nhân tạo và những ứng dụng của nó luôn rất tuyệt vời; cùng otec.com.vn tìm hiểu thêm nhiều điều thú vị bên cạnh ngành công nghệ này nhé.

Nguồn: quantrimang.com